Sin dudas, 2023 fue el año en el que la Inteligencia Artificial dio un enorme salto, pasando de ser una herramienta de nicho utilizada principalmente por investigadores, a convertirse en un instrumento funcional aprovechable por el público general. Ahora, cualquiera puede experimentar de forma gratuita y en primera persona, los alcances y la relevancia de su aplicación en la vida cotidiana.

Estudiantes, periodistas, programadores, entusiastas de la tecnología y un amplio espectro de curiosos la han incorporado de una manera u otra a través de diversas plataformas como el ya célebre ChatGPT de OpenAI, Bard de Google y Copilot de Microsoft, hasta generadores de imágenes como Dall-E, Stable Diffusion o Midjourney.

Algo que también logró la fiebre de los motores de IA generativa fue transformar a los asistentes de voz como Siri y Cortana, así como a los altavoces inteligentes como Alexa o Google Nest –hasta hace muy poco productos estrella– en dispositivos básicos y rudimentarios, envejecidos a una velocidad increíble. “Son tan tontos como una piedra”, dijo Satya Nadella, director ejecutivo de Microsoft, en una entrevista con el Financial Times en marzo de 2023.

Estos asistentes quedaron limitados a responder comandos simples, siendo incapaces de mantener una conversación fluida y natural con los usuarios, tal como lo hacen los chatbots conversacionales de IA. Sin embargo, es precisamente esta tecnología la que puede llegar a proporcionarles una nueva vida, revitalizándolos con capacidades más complejas y mayor flexibilidad, ofreciendo así una experiencia más satisfactoria y personalizada. Afortunadamente, este horizonte está cada vez más cerca.

En noviembre de 2023, Google anunció el lanzamiento “en los próximos meses” del Asistente de Google con Bard. Esta esperada integración de su chatbot de IA está siendo probada por un grupo selecto de usuarios, siendo éste usualmente el último paso antes de la implementación general de un producto, por lo que su despliegue podría comenzar tan pronto como el primer trimestre de 2024. Como sucede actualmente, el asistente podrá ser invocado diciendo “OK Google” en voz alta, a través de la app de Google, o, en dispositivos Android, deslizando el dedo desde una de las esquinas inferiores de la pantalla hacia el centro de la misma.

Gracias a una alianza multimillonaria con OpenIA, Microsoft es quien mejor ha sabido capitalizar las ventajas de la inteligencia artificial generativa, incorporándola prácticamente a todo su ecosistema de productos y contribuyendo a ganar una mayor cuota de mercado.

Sin embargo, en esta lucha intensa por acaparar la atención de un mayor número de usuarios, Amazon también está dando pelea. En septiembre, el gigante del comercio electrónico anunció una nueva versión de Alexa, ahora sí, con IA generativa. Con esto, la compañía de Jeff Bezos espera transformar la manera en la que se interactúa con el asistente, ofreciendo conversaciones más naturales y complejas y siendo capaz de recordar gustos y preferencias del usuario, adaptándose a su contexto.

Pero la inteligencia artificial, como un animal salvaje, ansía liberarse de la jaula de las aplicaciones para explorar los numerosos horizontes que propone el mundo real. Quiere abrirse paso hacia un terreno de descubrimiento y adaptación constante, extendiendo sus garras más allá de sus funcionalidades programadas, participando activamente de las decisiones de nuestra vida diaria. Esto, que apreciablemente podría parecer entre extravagante y ficcional, ya está sucediendo.

Humane es una startup tecnológica fundada por dos ex empleados de Apple con una larga trayectoria en la compañía de la manzana, Imran Chaudhri y Bethany Bongiorno. Esta pareja de esposos ha trabajado en el diseño y desarrollo del iPhone, iPad y Mac y en el desarrollo de software de varios productos de Apple. El pasado 20 de septiembre presentaron desde su nueva empresa un wearable revolucionario con el que buscan reemplazar al smartphone: el Pin IA.

Este dispositivo, una suerte de prendedor de alta tecnología, integra un asistente virtual basado en ChatGPT capaz de responder consultas, hacer búsquedas en internet y dar recomendaciones. Una cámara de 13 MP y un sensor de profundidad 3D le permite, además de tomar fotos, reconocer el mundo y los objetos alrededor; y un micrófono y un pequeño altavoz permiten comunicarse con el usuario y otras personas mediante llamadas y mensajes de texto.

De ser necesario, un proyector láser puede mostrar una interfaz visual en la palma de la mano, con la que se puede interactuar con movimientos de muñeca y los dedos índice y pulgar. La preventa de este revolucionario artefacto comenzó el pasado 16 de noviembre y las primeras unidades se entregarán a partir del próximo mes de marzo.

Por más increíble que parezca esta nueva forma de interactuar con el entorno y la información, la propuesta tecnológica de Humane tiene poco de humo y mucho de solidez. No solo cuenta con antiguos miembros del equipo de Apple, como Patrick Gates, quien fue director senior de ingeniería. También tiene el respaldo de inversores de enorme peso institucional, como Microsoft, Open IA, Qualcomm y Volvo.

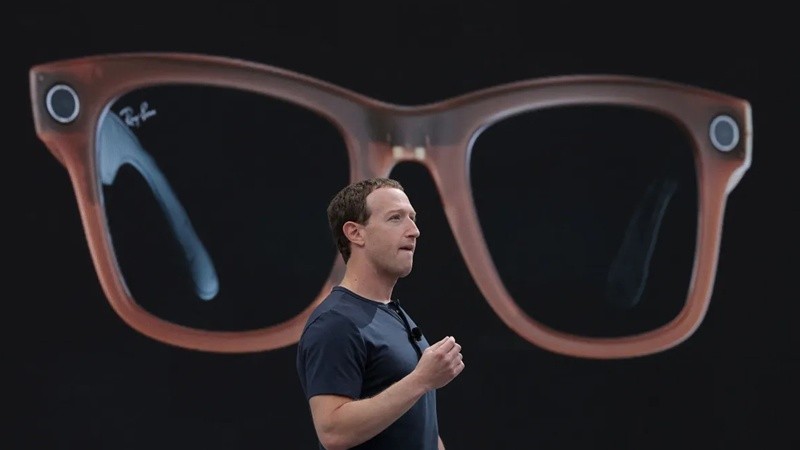

Pero hay una empresa que, silenciosamente, se encuentra a la vanguardia de los dispositivos portátiles de IA: Meta. A finales de septiembre, la empresa de Mark Zuckerberg lanzó su nueva colección de gafas inteligentes junto a Ray-Ban. Estos lentes incorporan una cámara de 12 MP, pequeños pero potentes parlantes en las patillas y cinco micrófonos capaces de tomar con precisión audio espacial. Esta configuración no solo sirve para compartir la vida en primera persona en redes sociales, sino que está especialmente orientada a interactuar con las impresionantes capacidades de la IA de Meta, disponibles desde el 12 de diciembre para los afortunados poseedores de estos lentes.

Para demostrar sus posibilidades, Zuckerberg compartió un video en el que le pidió al asistente de IA que le sugiriera unos pantalones que combinaran con la camisa que estaba mirando. Como respuesta, recibió algunas sugerencias muy sensatas. La palabra clave, una vez más, es el contexto. Las gafas pueden entender qué estamos mirando a través de la cámara incorporada, o distinguir a partir de su conjunto de micrófonos, desde dónde provienen los sonidos, como los ladridos de perros o la bocina de un tren que se aproxima.

Esto es apenas el comienzo. Florece ante nosotros un nuevo tiempo tecnológico, en el que los asistentes virtuales basados en IA nos susurrarán al oído y en tiempo real datos relevantes del mundo que nos rodea. Estos wearables enriquecerán nuestro día a día, superponiendo capas de información digital de forma natural sobre nuestro entorno físico. Desde el nombre de un viejo amigo que hace mucho que no vemos, hasta una serie de indicaciones de cómo llegar a destino proyectadas solo para nuestros ojos. Así, sigilosamente, la inteligencia artificial irá infiltrándose en cada rincón de nuestras vidas, preparando el terreno para una nueva era de interacción hombre-máquina que cambiará para siempre nuestra forma de relacionarnos con el mundo.